iPhoneと言えばセキュリティをウリにしてきました。

そのために たとえマスクしていたら 使いづらいと言われようと 顔認証を曲げずに貫き通し、SuicaなどのFeliCaも使用するたびにロックを外さなければならない。

アプリも厳重に?チェックするかわりに課金はアップル以外からは絶対に許さない など鉄壁な状況でユーザーの個人情報を守ろうとしてきました。

さらに広告にも規制をかけて追跡できなくしようとしたり、自分のユーザーだけ守れれば、ほかはどうでもよいという方針を貫いています。

ユーザーにとっては、これは、安全な高い壁の中で暮らしているようなもので多少の利便性を犠牲にしても 安心&安全は担保されてきました。

2021年8月5日、Appleは児童の性的搾取に関するデータ(CSAM)の拡散を防ぐための施策として、iPhoneの写真やメッセージをスキャンし、該当するコンテンツが存在しないかをチェックする施策を発表しました。

今回のIT小僧のブラック時事放談(ショートショート)では

iPhoneは、Appleに覗かれる? 児童の性的搾取(CSAM)拡散対策で内外から抗議

と題して何が問題になっているか考えてみよう

目次

最新ニュース

アップル、プライバシー保護の懸念を受けて児童性的虐待コンテンツへの言及をひっそり取り止め 2021年12月16日

Apple(アップル)は、iOS 15とmacOS Montereyにその新しい技術が組み込まれることを発表してから数カ月後、ウェブサイトから児童性的虐待スキャン機能に関するすべての言及を静かに削除した。

8月にAppleは、CSAMとして知られる児童性的虐待コンテンツを同社が検出し、法執行機関に報告することを可能にする機能を導入すると発表した。当時Appleは、すでに違法となりうるコンテンツをチェックするための包括的なスキャンを提供しているクラウドプロバイダとは異なり、画像やデバイスを取得することなく、またその内容を知らなくてもユーザーのデバイス上のCSAMを特定できる技術なので、ユーザーのプライバシーを保護しながら違法画像を検出することができると主張していた。

現在、この機能は完全に廃止された可能性があるようだ。

MacRumoursは、AppleのチャイルドセーフティのウェブページからCSAMに関するすべての言及がひっそりと削除されていることに最初に気づいた。12月10日まで、このページにはCSAM検出の詳細な概要と、この物議を醸す機能が「iOS 15、iPadOS 15、watchOS 8、macOS Montereyのアップデートで2021年後半に登場」するとの約束が含まれていた。更新されたバージョンのページでは、CSAM検出に関するセクションが削除されただけでなく、この技術に関するすべての言及と、CSAMプロセスを説明し評価する文書へのリンクを提供するセクションが削られている。現在、Appleのチャイルドセーフティページには、今週初めにiOS 15でデビューしたメッセージのコミュニケーションセーフティへの言及とSiri、Spotlight、Safari検索への拡張ガイダンスのみが含まれている

(いつものアップルらしく)こっそり なかったことにすることになったわけです。

社内でこのやり方に反対する人は、いなかったのであろうか?

アップルは、トップの指針を忠実に守ることが重要で社内の意見を聞かない社風かあるらしい。

以下の本を読むとアップルの異常さがわかると思います。

Appleは2019年からすでにiCloudメールを検閲していた? 2021年08月24日

2021年08月24日 12時06分 Gigazineによると 「Appleは2019年からすでにiCloudメールでCSAMコンテンツをスキャンしていたことが判明」という記事が掲載された。

Appleは2021年秋に公開予定のiOS 15から、iOSデバイス上やiCloudに保存された画像をスキャンして「児童の性的搾取に関連するデータ(CSAM)」をハッシュによりチェックする仕組みを導入すると、2021年8月5日付で発表しました。Appleの発表に対しては社内外から「ユーザーのセキュリティとプライバシーを損なう」という反発の声が上がっていますが、Apple関連の情報サイトである9to5Macが確認したところ、Appleは2019年からすでにiCloudメールでCSAMコンテンツをスキャンしていたことが判明しています。

Apple already scans iCloud Mail for CSAM, but not iCloud Photos - 9to5Mac

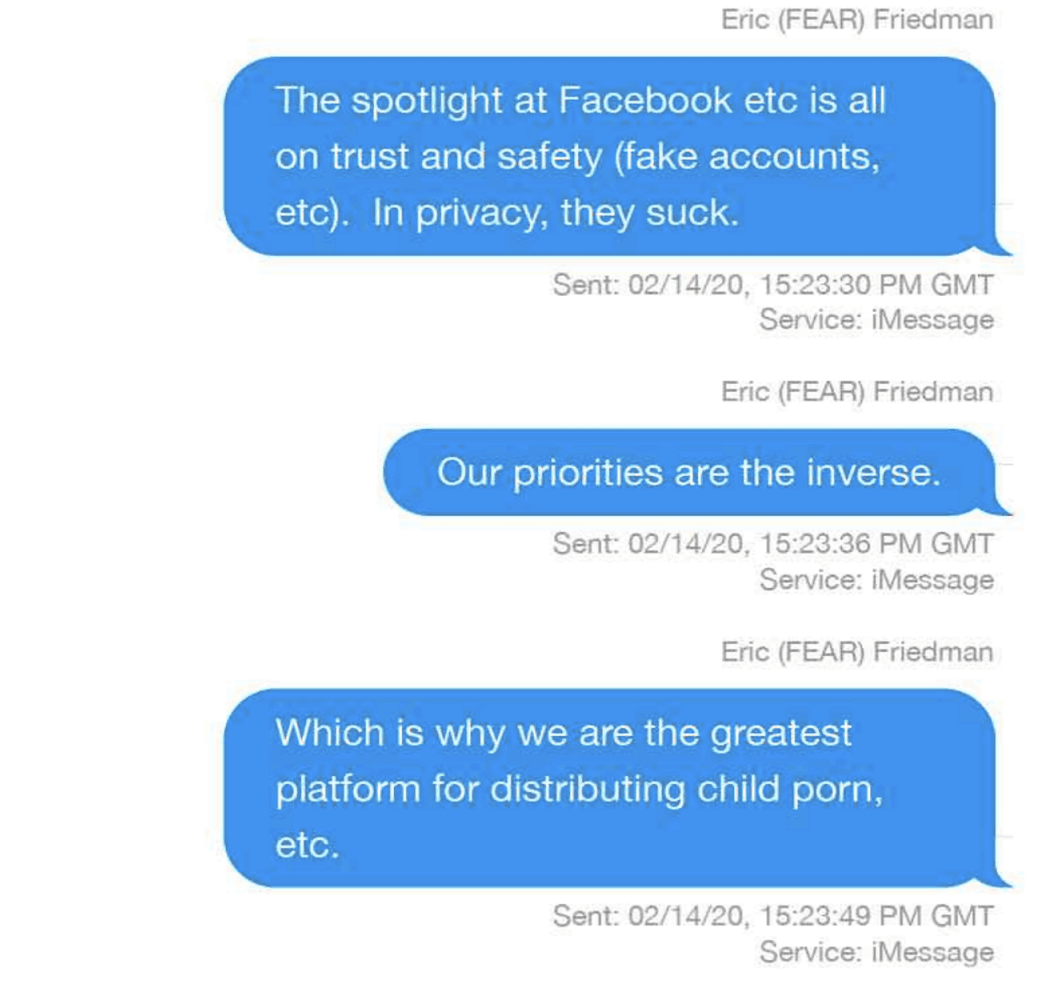

AppleがCSAMのスキャンを実施する決断に至った理由として、Apple製品のプライバシー保護の高さが、不正コンテンツの隠れみのになっているという考えがあります。2021年8月19日、ニュースメディアのForbesは、Appleの不正防止部門チーフのエリック・フリードマン氏が「我々は児童ポルノを配布するには最高のプラットフォームになってしまっている」という内容をiMessageで同僚に送信していたことを報じました。

Appleの関係者が、「Appleのプラットフォームは、児童ポルノの温床になっている」と同僚に送信

Apple関連の情報サイトである9to5Macのベン・ラブジョイ氏はそこで気がついた。

「なぜAppleは自社のプラットフォームに児童ポルノが多く存在すると知ることができたのか?」

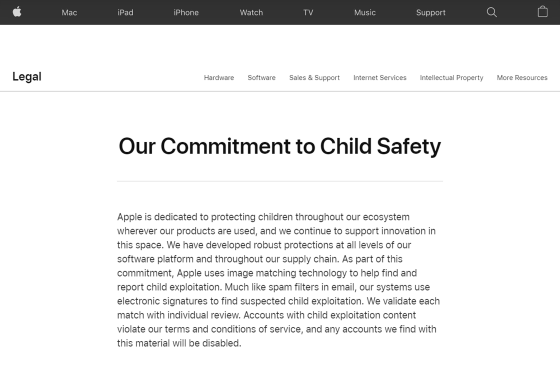

「Our Commitment to Child Safety(児童の安全に対する私たちの献身)」という記事を見つけて以下の記述を見つけました。

「Appleは児童搾取を発見・報告するために画像照合技術を利用しています。スパムフィルターのように、私たちのシステムは児童搾取の疑いがあるものの発見に、電子署名を使用します。照合されたものは個別にレビュー・検証されます。児童搾取のコンテンツを保有していたアカウントは利用規約に違反するとして、いかなるアカウントでも無効となります」

Appleが児童ポルノを配布するプラットフォームとして利用していることを同僚と話している内容

「Our Commitment to Child Safety(児童の安全に対する私たちの献身)」

という流れでラブジョイ氏がAppleni問い合わせたところ

「iCloudの写真をスキャンしたことは一度もない」

と返信したのですがその一方で

「2019年からiCloudメールについては送信・受信のいずれに対しても添付ファイルにCSAMが含まれないかスキャンしてきたことを認めた」

自動ポルノに関して欧米では神経質になっていて 英国では

孫が水浴びしている写真をパソコンの中に保存したおじいさん、児童ポルノ単純所持の罪で警察に捕まり起訴される

というように判定が難しく、はたしてAIで判定して通報・・・なんてことで大丈夫なんでしょうか?

iOS15の発表まで あと一ヶ月程度と予想されています。

いまさら CSAMの機能を外すかどうか? Appleはどう判断するのだろうか?

児童の性的搾取をしていないか 監視する

つまり 次のiOSでは、

「おまえらが、児童の性的搾取をしていないか 監視する」

と表明

「iPhoneの写真やメッセージをスキャンし、該当するコンテンツが存在しないかをチェックするぞ」

と発表しました。

内外から抗議

これに対してApple内外から抗議の声が出てきました。

Exclusive: Apple's child protection features spark concern within its own ranks -sources | Reuters

Apple employees express concerns about new CSAM scanning - 9to5Mac

Apple社内では、

8月5日にAppleがCSAM拡散防止システムを発表してから、社内のSlackチャンネル上には800件以上のメッセージが寄せられ、システムの是非に関する議論が繰り広げられているとのこと。なお、多くの社員が「抑圧的な政府が、人々を検閲したり逮捕したりするためにCSAM拡散防止システムを悪用するのでは」ということを懸念しているそうです。

https://gigazine.net/news/20210813-apple-employees-concerns-csam-scanning/

という声が上がってます。

Appleは、この声に対して「ユーザーのプライバシーを損なわない形でコンテンツを検閲」という声明を出しましたが、

結局、写真やメッセージをスキャンして判断するためには、全部、スキャンすることが必要なことになります。

AIスキャンで判断できるのか?

おそらく AIが監視することになると思いますが、AIは間違うし、AIのトップのGoogleでも間違いをすることがある。

YouTubeだってなぜ削除されたかわからない場合もみうけられる。

そんな中でCSAMと判断されてしまったら そのiPhoneの所有者になにかマークがつかないのだろうか?

要注意人物と判定されてしまう可能性も0ではない。

公式文書で「誤検知は年間1兆分の1以下」と表明しているか根拠が不明と指摘されてしまった。

確かにAIで写真をスキャンしているサービスは多い。

しかし、その内容で児童の性的搾取で判断するとは、していない。

単なる警告だけならよいのですが、それが可能だと知った当局はその先に進む可能性もあるだろう。

これに対してAppleは公的にるFAQを公開している。

Expanded Protections for Children Frequently Asked Questions(PDFファイル)

プライバシーは守られるし暗号化しているぞ

アップルは、その難題を解決するための新しい暗号技術システムを採用しようとしている。これにより少なくとも理論上は、プライヴァシー侵害を新たに引き起こすことなく、「iCloud」に保存された児童の性的虐待画像(児童ポルノ画像)を検知できるようになる。

WIREDより

またルールや暗号化も問題ない としている。

アップルの新しいシステムは、自社のデヴァイスやiCloudサーヴァーに保管されたユーザーの画像を単にスキャンするものではない。ユーザーが複数の児童性的虐待コンテンツ画像をアップロードしたと判断された場合に限り、アップルがそれらの写真を閲覧できるように設計されている。

また 暗号化を2重にほどこしているためプライバシーの確保ができていると発表

これを見る限り プライバシーと児童性的虐待の対応ができそうですが・・・

対応は簡単

対応としては、iCloudに写真をアップしなければよいので対応は可能です。

またメッセージをiMessageをつかわなければいいんでしょう?

検索は? 引っ掛かるかも知れないけど

政治利用

この技術は、Appleの試みとして賛否両論になっていますが、問題はこの技術を政治利用に発展する可能性もあるだろう。

特に中国では、すでにiCloudの鍵を事実上中国政府に渡しているのですでにプライバシーなどありません。

-

-

アップル社は、プライバシー重視します。 ただし、中国を除いてね

アップル社が、ことある毎に「個人情報を大事にしています」と宣伝をしています。

しかし「中国を除く」という但し書き(事実)が見えてきます。続きを見る

この問題の経過はどうなってゆくのか?

注目して 展開があったら記事をアップします。

最新ニュース

Apple urged to drop plans to scan iMessages, images for sex abuse

More than 90 policy and rights groups ask company to abandon plans for scanning phones of adults for images of child sex abuse.

Apple社に対して 90以上の政策および権利グループが、児童の性的虐待の画像について成人の電話をスキャンする計画を放棄するように求めています。

インターネットソサエティの独立ブラジル支部の会長であるFlavioWagnerは、

「私たちの主な関心事は、このメカニズムの結果であり、これを他の状況や他の企業にどのように拡張できる可能性があるからです」

スキャンする目的が児童の性的虐待としても これを拡張すれば個人の情報の中に「特定な機関にとって都合の悪いこと」を検索することに使われるかも知れない と心配している。

署名した他のグループには、アメリカ自由人権協会、電子フロンティア財団、アクセスナウ、プライバシーインターナショナル、Torプロジェクトなど 多くの団体が反対を表明している。