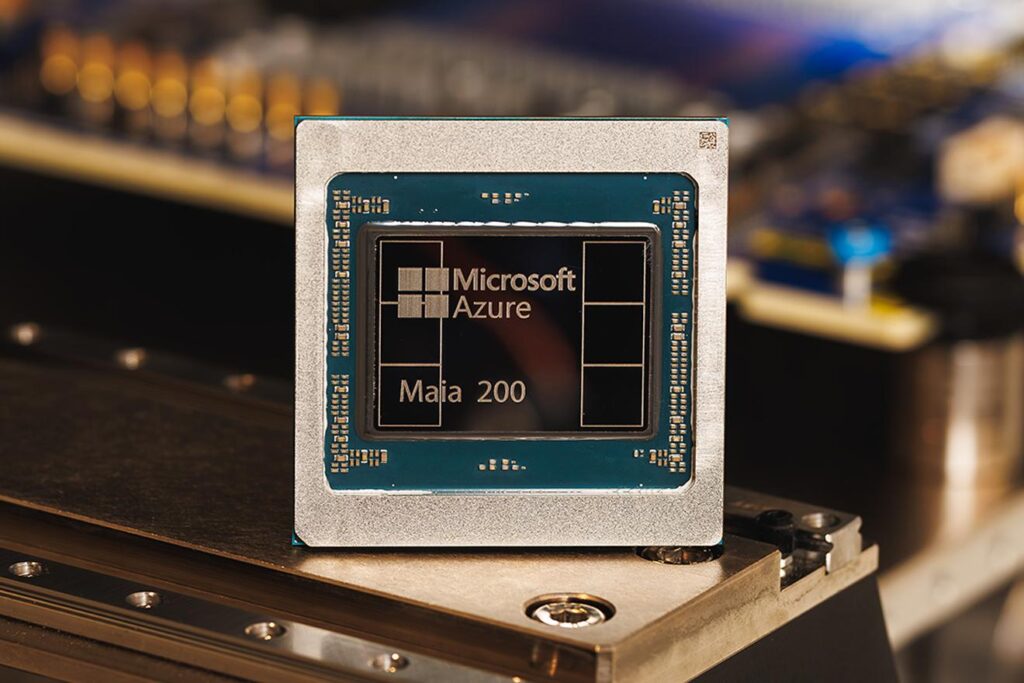

Microsoft は 2026 年 1 月、最新の AI 推論用チップ「Maia 200」を発表しました。

これは同社が長年依存してきた外部 GPU への依存を減らす戦略の一環であり、高い性能効率と大規模 AI 推論への対応力を強調するものです。

TechCrunch が報じた Maia 200 は前世代から大きく進化し、Nvidia や Google の AI チップと真っ向から競う性能を備えています。

本記事では Maia 200 の特長と、Nvidia、Google、その他の AI 推論チップとの性能・用途の違いをわかりやすく整理します。

目次

Microsoft Maia 200:次世代 AI 推論チップとは

Microsoft が発表した最新 AI チップ「Maia 200」は、推論(Inference)用途に特化した高性能プロセッサです。TechCrunch など複数報道によると、Maia 200 は 前世代 Maia 100 を大きく上回る性能を実現し、AI モデルの推論処理をより高速かつ低コストで実行できるよう設計されています。

Maia 200 チップは Taiwan Semiconductor Manufacturing Co(TSMC)の最先端 3nm プロセス によって製造されており、1000 億以上のトランジスタを搭載。これにより、推論処理の演算性能が飛躍的に向上しています。Te chCrunch は、4-bit 精度で 10 ペタフロップス超、8-bit でも約 5 ペタフロップスという高い性能を示すと報じています。

マイクロソフトはこれを 「シリコンのエンジン」 と表現し、Microsoft Azure の大規模 AI サービス(GPT-5.2 など)や Copilot 系機能の推論処理に活用していく計画です。

なぜ推論チップが重要なのか?

AI 推論チップとは、既に学習済みの AI モデルを実際のアプリケーションで使う際に発生する計算(質問への返答、画像生成、推論など)に最適化された半導体です。AI の推論要求が増えると、単純 CPU では速度や効率が追いつかないため、専用チップが不可欠となっています。

推論性能はリアルタイム性、処理速度、電力効率、そしてコストに直結するため、AI チップ戦略はクラウドやデータセンター運営者にとって極めて重要です。

他社推論チップとの比較:Nvidia・Google・AWS

Nvidia の GPU(Ampere / Blackwell)

Nvidia は AI チップ市場で長年主導的な位置を占めています。GPU(Graphics Processing Unit)は一般的に、AI 推論にも広く使われていて、CUDA という独自ソフトウェアエコシステムが高く評価されています。AI チップのランキングでも、Nvidia H200 や次世代 Blackwell 系が高い推論性能を示しています。

ただし、GPU は汎用性が高い反面、専用推論チップ(ASIC)よりも消費電力やコストの面で不利になる場合があります。

Google TPU(Tensor Processing Unit)

Google の TPU は、AI 推論とトレーニングの両方に使われる ASIC ベースの AI チップです。特に大規模 LLM(大規模言語モデル)の推論では、FP8 などの低精度演算性能が高く評価されており、Google Cloud で広く活用されています。

TPU は GPU より演算効率に優れる設計が特徴で、推論用途においても高いパフォーマンスを発揮しています。

AWS Trainium / Inferentia

Amazon Web Services(AWS)は、自社クラウド向けに推論・トレーニング用の Trainium や推論特化の Inferentia チップを開発しています。これらは AI 推論に最適化されており、低コストで多量の AI リクエストを処理するのに向きます。

Maia 200 の“強み”と差別化ポイント

Microsoft の Maia 200 は次のような特徴があります:

-

高い推論スループット性能:1000 億以上トランジスタと 3nm プロセスによる高い演算能力。

-

Azure 向け最適化:Azure の AI サービスに統合されることで、推論処理の効率化が図られる。

-

ソフトウェアツールの連携:推論チップを活用する SDK やツールチェーンも提供される方向で、開発者が扱いやすい環境になりつつある。

これにより、クラウド AI サービスの提供企業にとって コストと速度のバランスが最適化されることが期待されています。

市場全体の競争はどう進んでいるか?

AI 推論チップ市場は、GPU ベースだけでなく ASIC / カスタムチップが台頭しつつあります。Nvidia、Google、AWS 以外にも Groq、Cerebras のように 高い推論性能をうたう新興企業が存在します。

Cerebras は、AI 推論に特化した超大規模チップ(WSE-3 など)で非常に高速な推論処理を実現しています。

AMD も独自の NPU(XDNA)を含む AI 向けアーキテクチャを展開しています。

こうした状況を見ると、今後は 用途やワークロードに応じた「最適チップ」の選択肢が広がる時代に入っています。

まとめ:AI 推論チップの重要性と Microsoft の戦略

AI 推論チップは、AI 技術が実運用される現場において「速さ」「効率」「コスト」の優先度を左右します。Microsoft が発表した「Maia 200」は、Azure ベースの AI サービス向けに最適化された高性能推論エンジンであり、Nvidia、Google などの強力な競合チップと肩を並べられる性能を持っています。

特に 高性能でコスト効率に優れる推論チップが求められる今、Maia 200 の登場は AI ハードウェア市場にとって重要な節目になるといえるでしょう。

参考リンク

-

TechCrunch: Microsoft announces powerful new chip for AI inference

https://techcrunch.com/2026/01/26/microsoft-announces-powerful-new-chip-for-ai-inference/ -

Reuters: Microsoft Maia 200 details and competitive thrust

https://www.reuters.com/business/microsoft-rolls-out-next-generation-its-ai-chips-takes-aim-nvidias-software-2026-01-26/ -

The Verge: Maia 200 chip slides into AI arms race

https://www.theverge.com/news/867670/microsoft-maia-200-ai-chip-announcement -

UVation AI inference chip rankings guide

https://uvation.com/articles/ai-inference-chips-latest-rankings-who-leads-the-race/ -

Tom’s Hardware: Google Ironwood TPU overview

https://www.tomshardware.com/tech-industry/artificial-intelligence/google-deploys-new-axion-cpus-and-seventh-gen-ironwood-tpu-training-and-inferencing-pods-beat-nvidia-gb300-and-shape-ai-hypercomputer-model